Das Internet der Dinge (IoT) ist einer jener Begriffe, die sich inflationär in Nachrichten, Vorträgen und Veröffentlichungen finden und deren häufige Verwendung zum schnellen Überdruss beim geneigten Leser führen. Die natürliche Reaktion auf das Auftreten solcher Modebegriffe ist das Abwarten, ob die Welle nicht genauso schnell abklingt wie sie aufgekommen ist.

Wiewohl einzelne Begriffe und Schlagwörter wieder zu Recht im Orkus des Vergessens verschwinden werden, so ist doch mit an Sicherheit grenzender Wahrscheinlichkeit davon auszugehen, dass die hinter den Begriffen stehende Problematik bestehen bleibt, ja sogar immens an Grösse und Bedeutung gewinnen wird:

1. Die Datenmengen werden immer grösser.

Zu dieser Behauptung werden jedem Einzelnen sicherlich genügend Beispiele der letzten Zeit einfallen. Ob es nun selbstfahrende Autos sind, die einen Strom an Daten aussenden und empfangen, ob es die Supermarkt-Sparkarten sind, die unser Konsumverhalten nicht nur verbilligen, sondern auch registrieren, ob es neue Apps auf den Smartphones oder Smartwatches sind, die uns nicht nur unterstützen, sondern auch kategorisieren, die Liste an Beispielen ist nicht nur bereits lang, sie scheint auch mit immer höherer Geschwindigkeit an Länge zu gewinnen.

Gelegentlich fällt einem diese Entwicklung an einzelnen Beispielen besonders auf. So stach mir ein Bericht auf SPIEGEL ONLINE vom 15.11.2017 ins Auge, in dem von einer Pille berichtet wurde, die ihre Einnahme meldet und die Daten in die Cloud sendet: Sinn und Zweck dieser Pille mit Daten ist die Überwachung der regelmässigen Einnahme von Medikamenten. Sofort stellen sich weitere Fragen: meldet die Pille auch, wenn sie z.B. innerhalb einer Stunde den Körper wieder verlassen hat (das lässt auf Erbrechen schliessen, damit zählt die Pille als nicht eingenommen)? Meldet sie weitere Zwischenstationen auf dem Weg durch den Körper? Dieses Beispiel zeigt sehr deutlich, wie wir als Personen zur Quelle eines Datenstroms werden, der in seinen Ausmassen ins Ungeheure anwachsen kann.

2. Die Datenqualität ist eher mässig gut.

In der Masse von Daten und Meldungen sind Fehler mit grösserer Häufigkeit vertreten. Es kommt nun mal zu temporären Falschmeldungen (Sensor defekt, die Smartwatch kann aufgrund von körperlicher Bewegung mal für eine Zeit die Herzfrequenz nicht ermitteln, usw.) und aufgrund der Masse an Daten ist es nicht möglich, sich die Zeit zu nehmen, alle falschen Daten zu finden und zu eliminieren. Sind falsche Daten systematisch erkennbar, so können sie sicherlich ausgefiltert werden und bei grösserer Zahl lohnt es sich dann auch zu versuchen, die Ursache zu beseitigen. Aber allein aufgrund der grossen Zahl an Datenlieferanten muss man einen Bodensatz an falschen Werten akzeptieren und in Kauf nehmen.

Aus der Sicht eines Enterprise Data Warehouse ergeben sich damit neue Herausforderungen:

- Neue Datenquellen können plötzlich und in grosser Zahl hinzukommen. Die Verknüpfung dieser Daten ermöglich ganz neue Auswertungen und Erkenntnisse. Es ist aber ein hohes Mass an Flexibilität und Agilität nötig, um diese Datenräume verfügbar zu machen.

- Die Datenmengen sind potenziell riesig. Es ist gut möglich, dass sich das Datenaufkommen z.B. um einen Faktor 1000 vergrössert. Wenn daraufhin sich die Berichtsanzahl um den Faktor 1000 vergrössert oder einzelne Berichte nun 1000 Mal länger sind, wird sich die Begeisterung der Anwender in Grenzen halten. Der Mehrwert des Data Warehouses besteht ja gerade darin, durch eine Verdichtung erst einen Blick für das Ganze zu bekommen und nur für gewisse Einzelanalysen den Abstieg bis auf den einzelnen Datensatz zu ermöglichen.

- Die Verknüpfung mit qualitativ hochwertigen Stammdaten bringt den Mehrwert. Die Masse an Bewegungsdaten bietet die Gefahr, dass ihre Auswertung in Beliebigkeiten endet. Man sieht, was man sehen will oder was sich eher zufällig ergibt. Hat man beispielweise die Verkaufsumsätze einzelner Ladengeschäfte, so ist aus den Verkaufsumsätzen allein schlecht abzulesen, warum sich ein Artikel mal gut und mal schlecht verkauft. Nimmt man aber die Stammdaten der Läden hinzu, wie z.B. Grösse des Ladens, Öffnungszeiten, Lage des Ladens, so sind die Ergebnisse deutlich belastbarer.

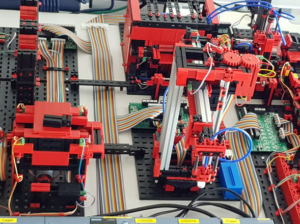

Im nächsten Teil dieses Blogs werde ich erläutern, welche unmittelbaren Konsequenzen sich für die Architektur eines SAP BW mit Big Data ergeben und hier taucht dann auch die Fischertechnik-Fabrik zum ersten Mal auf.