Business Analytics und Data Governance sichern den nachhaltigen Erfolg, wenn sie in die richtige Balance gebracht sind. CubeServ unterstützt viele namhafte Kunden bei diesem Vorhaben.

Das Konzept der Business-Analytics-Plattform hilft Ihnen, Ihre Daten zu organisieren, dass jeder sie nutzen kann. Es bildet die Basis für ein einheitliches Verständnis über die zugrundeliegenden Ereignisse und Prozesse. Wir schaffen die Voraussetzung dafür, dass Sie Ihr Unternehmen oder Ihre Organisation faktenbasiert und erfolgreich führen.

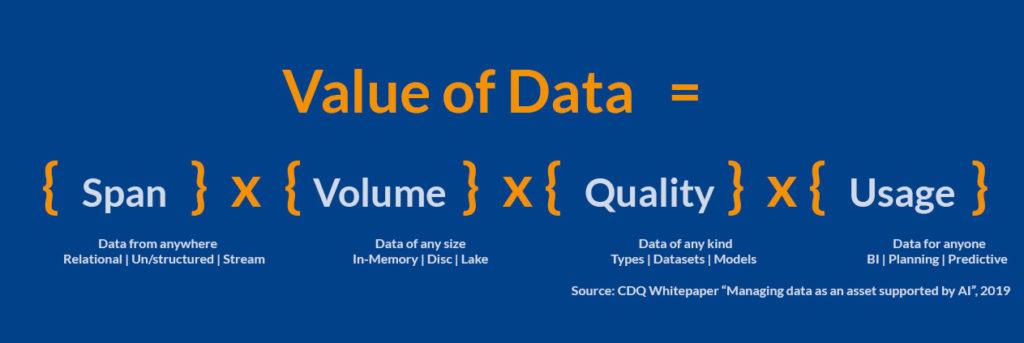

Die Gewinnung von Werten aus Informationen ist in erster Linie keine Frage der Datenmenge. Mit der Art und Weise der Ressourcennutzung entscheiden Sie über den Erfolg. Nicht die Datenmenge oder die eingesetzte Technologie unterscheidet den Ansatz.

Selbst die besten Unternehmen im Bereich Analytik nutzen nicht immer die neuesten Tools. Ihnen kommt jedoch das Vorgehen zugute, ihre Strategien und Geschäftsmodelle, um ihre analytischen Fähigkeiten herum aufzubauen. Personen, die glauben, dass Fakten die besten Leitfäden für Entscheidungen und Handlungen sind, führen solche Unternehmen. Sie machen Daten und Analytik zu integralen Bestandteilen ihrer Firmenkultur.

Analytics 1.0 war (oder ist, sollten Sie es immer noch verwenden) stark auf deskriptive Analytik ausgerichtet, d.h. auf Berichte und visuelle Darstellungen, die das in der Vergangenheit Passierte erklären. Dahingegen verwenden wir die Analytik hier nicht, um in die Zukunft zu blicken (Predictive Analytics) oder Empfehlungen auszusprechen, wie wir eine bestimmte Aufgabe besser erledigen (Prescriptive Analytics). Im vergangenen Jahrzehnt verbrachten wir viel Zeit, Unternehmen zu ermutigen, über rein deskriptive Analysen hinauszugehen.

Mit Insights näher am Kunden

Erfolgreiche Unternehmen arbeiten kundenorientiert. Die mit den sich heutzutage schnell verändernden Bedürfnissen der Kunden und ihrer Kaufgewohnheiten einhergehenden Herausforderungen können wir meistern, indem wir die entsprechenden Signale zielgerichtet verarbeiten.

Zwar verfügen viele Firmen heutzutage in der Regel über grosse Mengen an Kundeninformationen; allerdings unterbleibt häufig die Analyse dieser Daten, oder sie wird nur rudimentär betrieben.

Geschichten sprechen das Gehirn auf allen Ebenen an: intuitiv, optional, rational und somatisch. Wenn wir Geschichten hören, reagieren unsere Gehirne, indem sie die Informationen besser verstehen. Das limbische System (der emotionale Teil des Gehirns) setzt Chemikalien frei, die unser Verbundenheitsgefühl und unser Belohnungszentrum stimulieren.

Wenn Sie Ihre Zuhörer in den Mittelpunkt Ihrer Geschichte rücken, geben Sie Ihnen das Gefühl, Helden zu sein. Geschichten bewegen uns zum Handeln. Die Reaktionen, die unser Gehirn auslöst, rufen möglicherweise ein Gefühl von Empathie, Dringlichkeit oder grosser Betroffenheit hervor.

In einer Studie wurden die neuronalen Reaktionen der Teilnehmer gemessen: die Menschen lauschten einer Geschichte über die Beziehung eines Vaters zu seinem jungen, sterbenden Sohn. Insbesondere zwei Emotionen standen im Vordergrund: Bedrängnis und Empathie.

Die Studienleiter begutachteten die Teilnehmer sowohl vor als auch nach dem Hören der Geschichte. Es zeigte sich ein erhöhter Anstieg von Cortisol, das einen Menschen fokussierter und aufmerksamer werden lässt, und Oxytocin, das Wohlbefinden und Empathie auslöst. Die verblüffendste Erkenntnis war:

Erzählungen verändern die Chemie in unseren Gehirnen und bringen uns zum Handeln. Fesselnde Geschichten bewirken, dass wir uns emotional an andere binden und uns motiviert fühlen, eine bestimmte Handlung zu beginnen.

Geschichten gestalten

Mit Daten kommunizieren wir, um zu führen. Es gibt einen ununterbrochenen Buzz über Daten: Big Data, Small Data, Deep Data, Thick Data und Maschinen, die lernen, Daten zu analysieren. Viele Organisationen entwickeln innovative Dinge, die unser Leben verbessern sollen. Im Mittelpunkt stehen – Sie haben es erraten – Daten. Natürlich werden nicht alle Antworten auf organisatorische Probleme oder Möglichkeiten einem Algorithmus entspringen. Daten beschränken sich auf die Aufzeichnung der Vergangenheit, indem sie numerische Artefakte des Geschehenen katalogisieren.

Die Suche nach der historischen Wahrheit ist ausschlaggebend für eine Entscheidungsfindung; diejenigen, die mit Daten arbeiten, sind von Natur aus Wahrheitssuchende. Wenn Sie jedoch in eine Führungsposition hineinwachsen, werden Sie Ihre meiste Zeit damit verbringen, mit anderen über den zukünftigen Zustand zu kommunizieren, den Sie schaffen wollen.

Die Kommunikation von Daten formt unsere zukünftige Wahrheit – unsere Fakten. Gut zu kommunizieren ist von zentraler Bedeutung, um die Zukunft zu gestalten, in der Menschen und Organisationen gedeihen sollen. Erkenntnisse aus der Vergangenheit geben uns sowohl die Richtung vor, in die wir gehen, als auch die Massnahmen, die wir ergreifen müssen. Andere dazu zu bringen, sich mit diesen Massnahmen vorwärtszubewegen, ist allerdings nur mit einer guten Kommunikation möglich.

Mit Daten führen

Cole Nussbaumer Knaflic empfiehlt sechs einfache Schritte in „Storytelling mit Daten„:

- Kontext verstehen

- Angemessene visuelle Darstellung wählen

- Wirrwarr entfernen

- Aufmerksamkeit in eine gewünschte Richtung lenken

- Wie ein Designer denken

- Geschichte erzählen

Wenn wir unsere Botschaft auf die Empfänger zuschneiden, lösen wir die gewünschten Handlungen aus. Es zählt, was beim Empfänger ankommt.

Die besten Referenten stellen Daten prägnant und klar strukturiert dar. Gleichzeitig erzählen sie eine überzeugende und einprägsame Geschichte. In unseren Vorträgen lenken

wir die Aufmerksamkeit des Publikums bewusst, indem wir unsere Ergebnisse in den Mittelpunkt stellen und eine visuelle und verbale Klarheit schaffen. Für mich ist wichtig, effizient und inspirierend zu kommunizieren. Hierfür ist das richtige Mass an Informationen entscheidend.

Die sechs Schritte zu einer klaren Geschichte kann jeder leicht anwenden. Angesichts der Vielfalt an Datentypen und der unterschiedlichen Verfahren der Anwender bin ich davon überzeugt, dass wir in den meisten Fällen verschiedene Ansätze (Technologien und Produkte) kombinieren müssen, um herausragende Ergebnisse und eine hohe Akzeptanz im Unternehmen zu erzielen. Es gilt, das richtige Mass an Vielfalt und Standardisierung zu finden. Weder ein einziges Programm noch ein Tool-Zoo (für jeden Anwender ein anderes Programm) sind in meinen Augen eine gute Lösung. Jedes Unternehmen hat unterschiedliche Bedürfnisse und soll individuelle und adäquate Ansätze zu entwickeln.

Wir als CubeServ sind darauf spezialisiert, uns den unterschiedlichen Anforderungen anzupassen, Lösungsalternativen zu erarbeiten und sie gemeinsam mit den Anwendern zu bewerten.

Vier Megatrends für die Zukunft

=> AI Plattformen as a Service

Klang künstliche Intelligenz (KI) vor einigen Jahren noch nach Zukunftsmusik, kommt sie heute eher unscheinbar daher und schleicht sich heimlich, still und leise in unseren Alltag. Es ist vielen Menschen nicht bewusst, dass sie täglich KI-Tools nutzen. Sprachbasierte Assistenten wie Alexa, Siri oder Google Assistant werden von vielen als selbstverständlich wahrge-nommen. Dabei lernen die schlauen Assistenten durch maschinelles Lernen kontinuierlich hinzu und werden kontinuierlich besser; sie interpre-tieren Anliegen richtig und reagieren entsprechend.

=> IoT-Plattformen und Blockchain

Die Netzwoche titelte: „Die Cloud – Türe ins Internet of Things“. Das In-ternet of Things (IoT), zu Deutsch „Internet der Dinge“, entsteht, indem mehr und mehr „Objekte“ mit dem Internet verbunden sind und „Ob-jektdaten“ in das Internet senden. Um dies zu ermöglichen, braucht es „Sensoren“, welche die Objektdaten erfassen und drahtgebunden oder drahtlos in das Internet übermitteln. Die Industrie schätzt, dass bis 2020 weltweit 50 Milliarden Objekte mit dem Internet verbunden sein wer-den; Objekte, die Daten senden, die gespeichert werden müssen, damit sie ausgewertet werden können. Für die exponentiell wachsende Daten-flut (Big Data) dient die Cloud als Speicher. Für die Datenanalyse braucht es zudem Cloud-ready-Applikationen.

=> Smart Workplaces & Streaming Analytics

Unternehmen erkannten während der Krise, dass sie sowohl nach COVID-19 als auch während der Krise eine digitale Resilienz in der gesamten Belegschaft entwickeln müssen. Tatsächlich war es dieses Gerangel um den Aufbau von Technologie-Stacks während der Pandemie, das zur Entwicklung dessen führte, was Gartner als „Smart Workplace“ beschreibt.

=> Über Cloud-Plattformen stets verfügbar sein

„Cloud Computing“ ist die bedarfsabhängige Bereitstellung von IT-Ressourcen über das Internet zu nutzungsabhängigen Preisen. Statt physische Rechenzentren und Server zu besitzen und zu unterhalten, können Sie über einen Cloud-Anbieter wie Amazon Web Services (AWS) nach Bedarf auf Technologieservices wie beispielsweise Rechenleistung, Speicher und Datenbanken zugreifen.

Der Plattform-Gedanke

Unternehmen und Menschen stehen unter Handlungsdruck. Sich ändernde Rahmenbedingungen erzwingen schnelle Veränderungen. Die Business Analytics Plattform ist die Ausgangsbasis zur Bewältigung neuer Datentypen und -kombinationen. Wir erhalten permanent neue Einsichten; proaktiv bereiten wir Optionen für das Unbekannte vor.

Bestehende Geschäftsmodelle werden besser verstanden und mit neuen Datentypen optimiert.

Das Potential digitaler Service wird früh erkannt und neuer Kundennutzen wird generiert.

Warum das Data Warehouse den Kern der Plattform bildet

Single Source of Truth (SSOT) ist ein Konzept, mit dem sichergestellt wird, dass jede in einer Organisation getroffene Geschäftsentscheidung auf den gleichen Daten basiert.

Um ein SSOT einzurichten, werden die relevanten Mitarbeiter mit einer Quelle ausgestattet, die die benötigten Datenpunkte speichert. Die datengetriebene Entscheidungsfindung erhielt mit dem Sammeln und Analysieren von Daten eine noch nie dagewesene Bedeutung. Das Handeln auf der Grundlage von datengestützter Geschäftsintelligenz ist heutzutage für wettbewerbsfähige Marken unerlässlich ist. Unternehmen verbringen oft viel zu viel Zeit mit debattieren, welche Zahlen (ausnahmslos aus unterschiedlichen Quellen stammend) die richtigen Zahlen sind.

Durch die Einrichtung einer Single Source of Truth (einer Quelle der Wahrheit) wird dieses Problem beseitigt. Anstatt über die zu verwendenden konkurrierenden Datenquellen für Unternehmensentscheidungen zu debattieren, kann jeder dieselbe, einheitliche Quelle für seine Datenbedürfnisse nutzen.

Sie stellt Daten zur Verfügung, die von jedem und auf jede Art und Weise im gesamten Unternehmen verwendet werden können.

Die SAP-Applikationen stellen neben den Daten über Metadaten (Hierarchien, Attribute, Mehrsprachigkeit, Umrechnungen) sicher, dass die Daten richtig interpretiert werden können. Somit sind S/4HANA, BW/4HANA und die Datawarehouse Cloud wichtige Bausteine einer analytischen Plattform.

Neben den klassischen Geschäftsdaten (FI/CO, SD etc.) spielen neue Datentypen (Social Media, Bilder, Töne etc.) eine grosse Rolle für analytische Fragestellungen. Sie können in speziellen Technologien besser und kostengünstiger gespeichert und analysiert werden. Die analytische Plattform muss ergänzt werden (Objektspeicher, Hadoop etc.).

Die Datenanforderungen im Enterprise Data Warehouse sind hoch. Deshalb verursachen Änderungen an den Strukturen oder den Ladeläufen hohe Kosten. Anwender benötigen häufig nicht diese hohe Qualität für Prototypen etc., sondern flexible Strukturen. Die analytische Plattform muss mit Data Warehouse Cloud und mit lokalen Strukturen ergänzt werden.

Analytische Fragestellungen werden mit neuen Methoden angegangen: daher ist es wichtig, offene (OpenSource: R und Python) und komfortable Applikationen

(Process Mining wie Celonis, PowerBI und/oder Tableau) in die Plattform zu integrieren.

SAP-Referenz: Business Technology Platform

Referenzarchitektur für eine digitale Transformation- Entwicklung einer voll integrierten Self-Service- und einer Advanced-Analytics-Plattform für alle Interaktionen und Benutzergruppen.

- Diese dient als Framework mit Anwendungs- und Infrastruktur-Services für die Konvertierung verschiedener Datentypen und die Integration verschiedener Schnittstellen, Quell- und Zielsysteme.

- Agilität durch Kopplung verschiedener Informationssysteme in einem logischen Data Warehouse mit Realtime Data Warehouse & Analytics Lab.

- Agiles Echtzeit-Datenmanagement mit strukturierten Geschäftsdaten und unstrukturierten Big Data aus dem Data Lake. Anwender nutzen agile Daten aus verschiedenen Quellen. SAP HANA verbindet operative und analytische Systeme auf einer Plattform.

- SAP S/4HANA bildet den «digitaler Kern» für Embedded Operational Reporting.

- SAP BW/4HANA als «zentrales DWH» für descriptive und predictive Analysis –mit Datentypen aus IoT und Data Lakes. SAP Data Warehouse Cloud ergänzt das core-System als «digitales Framework».

Die Daten im SAP S/4HANA reichen für viele Szenarien nicht aus. Wir gewährleisten den Schutz der Daten in dem wir dies bei der Konzeption von Business Analytics und Data Governance berücksichtigen.

Building Blocks der Business Analytics Plattform

Das Konzept der billigen Blocks wird in dem Enterprise Architecture Framework TOGAF verwendet. Folgende Lösungsbestandteile haben einen generelleren Anwendungscharakter, d.h. sie können als Schablonen verwendet werden, um gleichartige Probleme zu lösen.

Bausteine haben die folgenden generischen Eigenschaften:

- Ein Baustein ist ein Paket von Funktionen, die definiert sind, um die geschäftlichen Anforderungen in einem Unternehmen zu erfüllen.

- Ein Baustein hat veröffentlichte Schnittstellen für den Zugriff auf die Funktionalität.

- Ein Baustein kann mit anderen, voneinander abhängigen Bausteinen interagieren.

Ein guter Baustein hat folgende Eigenschaften:

- Aufbau eines durchgängig integrierten Self-Service und einer Advanced Analytics Plattform für sämtliche Interaktionen und Anwendergruppen.

- Dies dient als Framework mit Anwendungs- und Infrastruktur-Services für die Konvertierung verschiedenster Datentypen und die Integration von diversen Schnittstellen, Quell- und Zielsystemen.

- Agilität durch Kopplung unterschiedlichster Informationssysteme in einem logischen Data Warehouse mit Realtime Data Warehouse & Analytics Lab.

- Agiles Echtzeit Daten-Management mit strukturierten Geschäftsdaten und unstrukturierten Big Data aus dem Data Lake. Anwender nutzen agile Daten verschiedener Quellen. SAP HANA verknüpft operationale und analytische Systeme zu einer Plattform.

- SAP S/4HANA bildet den «digitaler Kern» für Embedded Operational Reporting.

- SAP BW/4HANA als «zentrales DWH» für descriptive und predictive Analysis –mit Datentypen aus IoT und Data Lakes. SAP Data Warehouse Cloud ergänzt das core-System als «digitales Framework».

Ein Baustein ist ein definiertes Funktionalitätspaket, um bestimmte Geschäftsanforderungen zu erfüllen. Die Organisation setzt die Art und Weise wie Funktionalität, Produkte und kundenspezifische Entwicklungen zu Bausteinen zusammengesetzt und wird in den einzelnen Architekturen sehr unterschiedlich sein.

Jede Organisation entscheidet, welche Anordnung von Bausteinen für sie am besten funktioniert. Eine geeignete Auswahl von Bausteinen kann zu Verbesserungen bei der Integration von Altsystemen, der Interoperabilität und der Flexibilität bei der Erstellung neuer Systeme und Anwendungen führen.

Systeme bestehen aus Sammlungen von Bausteinen; es müssen die meisten Bausteine mit anderen Bausteinen interagieren.

In diesem Fall ist es wichtig, die annähernd stabil Schnittstellen zu einem Baustein zu veröffentlichen.

Wir empfehlen, beim Design der Business Analytics Plattform acht verschiedene Layer vorzusehen:

- Rohdaten aus den Prozessen

- Data Aquisition Layer-Rohdaten

- Single Source of Truth

- Multiple Versions of Truth

- Service Layer

- Prozess Layer

- Interaction Layer

- Multi Channel Delivery

Datenbanken und SAP-Systeme auf Basis von SAP HANA virtuell anbinden

Auf SAP HANA werden die verschiedensten Technologien für die Datenhaltung zusammengefasst. Es empfiehlt sich, für eine regelmässige Benutzung innerhalb des SAP HANA Stack die Daten zu modellieren, dass der Transfer zu der SAP HANA auf ein Minimum reduziert wird. Anders sieht dies für den explorativen Zugriff aus; hier sind längere Verarbeitungszeiten aufgrund des seltenen Zugriffs akzeptabel.

Für die Einbindung der verschiedenen anderen Technologien stehen auf der Ebene der SAP HANA insbesondere Smart Data Access (SDA) sowie Smart Data Integration (SDI) zur Verfügung. Mit SDA bzw. SDI können Daten in heterogene Enterprise-Data-Warehouse-Landschaften (Datenverbund) zusammengeführt und zur Analyse miteinander kombiniert werden. In früheren SAP-Werkzeugen wurden sämtliche Daten vorab eingestuft, indem sie auf einer Datenbank abgelegt wurden. Im Gegensatz dazu können Sie mit SDA remote auf Daten zugreifen, ohne vorher die Daten in der SAP-HANA-Datenbank replizieren zu müssen. SDA wird unter anderem für Teradata-Datenbanken, SAP Sybase ASE, SAP IQ, Intel Distribution für Apache Hadoop und SAP-HANA-Instanzen verwendet. SAP HANA verarbeitet die Daten wie lokale Tabellen in der Datenbank.

Dank der automatischen Datentypkonvertierung ist es möglich, Datentypen aus Datenbanken abzubilden, die über SDA mit den SAP-HANA-Datentypen verbunden sind. Bei SDA verbleiben die Daten aus anderen Quellen in virtuellen Tabellen. Innerhalb von SAP HANA erstellte virtuelle Tabellen verweisen auf Remote-Tabellen in den gekennzeichneten Datenquellen. Diese Verbindungen ermöglichen einen Echtzeitzugriff auf die Daten, unabhängig vom Speicherort. Gleichzeitig wirken sie sich nicht auf die SAP-HANA-Datenbank aus. Autorisierte Benutzer können anschliessend SQL-Querys in SAP HANA schreiben, die auf virtuellen Tabellen arbeiten. Der SAP-HANA-Query-Prozessor optimiert die Querys und führt den relevanten Teil der Querys in der angeschlossenen Datenbank aus, gibt das Ergebnis an SAP HANA zurück und schliesst die Operation ab.

Die Query-Ausführung wird mit SDI oder SDA optimiert, indem mit SQL-Querys auf virtuellen Tabellen in SAP HANA gearbeitet wird. Um Beziehungen und Verknüpfungen anzulegen, verbinden Sie Fakten und Stammdaten von der Quelle über Assoziationen im Open ODS View. Diese Fakten und Stammdaten sowie Operationen auf den Navigationsattributen werden zur Query-Laufzeit direkt auf Datenbankebene verknüpft. Für Open ODS Views können Sie mit SDA nicht vom SAP-BW-System verwaltete Datenquellen verwenden, jedoch ohne grossen Aufwand: die Modellierung im SAP-BW-System erweitern, in SAP-HANA-Tabellen gespeicherte persistente Daten verwenden und eine offene ETL-Verbindung zwischen externen Systemen und Ihren virtuellen Tabellen herstellen.

Hierdurch kann mit Rohdaten aus den Prozessen, der erste Layer modelliert werden.

Nicht auf alle Daten kann virtuell zugegriffen werden. Somit brauchen wir in der Business Analytics Plattform einen Ort, wo solche Daten abgelegt werden: Data-Aquisition-Layer-Rohdaten.

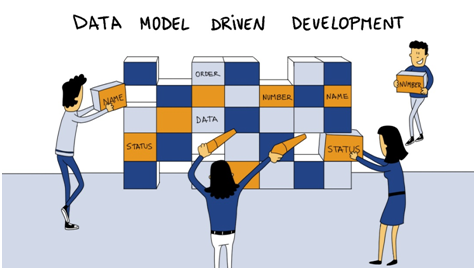

Enterprise Data Model

Das Enterprise Data Model sollte in einem eigenen Layer abgebildet werden. In unserer Referenzarchitektur ist das der dritte Layer: Single Source of Truth. Dieser kann in verschiedenen Technologien realisiert werden. Wir empfehlen hierfür den datenmodellgetriebenen Ansatz. Die Anforderungen an das Enterprise Data werden hierbei zuerst modelliert.

Wir sprechen von dem konzeptionellen Datenmodell bzw. dem logischen Datenmodell. Daraus leitet sich das physische Datenmodell für das jeweilige Datenbanksystem ab, das automatisiert bzw. teilautomatisiert erstellt wird. Diese Herangehensweise hat den Vorteil, dass Änderungen einfach im Datenmodell nachvollzogen werden können. Hierdurch ist ein interaktives Vorgehen möglich.

Auf dem Layer mit dem Enterprise Data Model baut sich eine eigene Schicht für private Zwecke auf. Das können sandboxed Daten oder Datenmodelle, die sich in lokaler Beantwortung befinden, sein. Diese Schicht nennen wir: Multiple Versions of Truth.

Auf Grundlage der Daten werden verschiedene zentrale Services angeboten. Typische Beispiele hierfür sind Planungs-Services, Kommentierungs-Services oder das Data Mining bzw. Methoden des Advanced Analytics. All diese Services befinden sich in den Service-Layern.

Daten und Services werden in Applikation zusammengeführt. Diese befinden sich im Prozess-Layer.

Die beiden letzten Layer: Interaction Layer (der User oder auch Prozesse greifen auf die Plattform zu) und Multi Channel Delivery (die Ergebnisse werden über verschieden Kanäle verteilt).

Bei der Auswahl der Technologien werden die unterschiedlichen Anforderungen und die Kosten der Umsetzung berücksichtigt. Neben dem Data Warehouse sehen wir häufig einen Data Lake. Es ist deshalb nicht sinnvoll, die Daten an einem Ort zu konsolidieren; die unterschiedlichen Technologien bringen verschiedene Vorteile mit sich bringen. Des Weiteren möchten wir einen technologischen und organisatorischen Flaschenhals in unserer Architektur vermeiden.

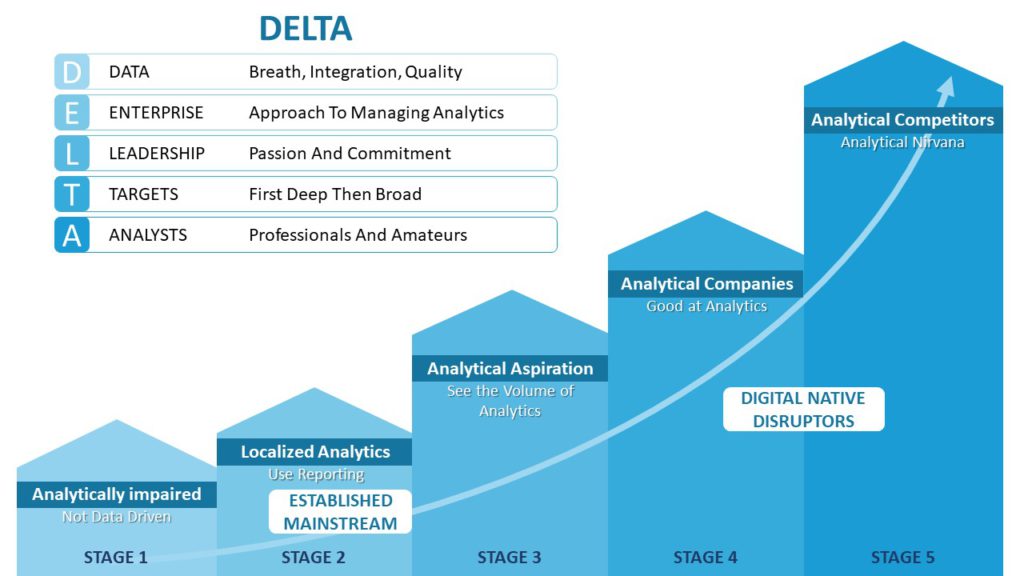

Das Delta-Model: mit Analytics den Wettbewerb gestalten

Was braucht es, um ANALYTICS in Ihrem Unternehmen einzusetzen? Welche Fähigkeiten und Ressourcen benötigen Sie, um mit Analytik-Initiativen erfolgreich zu sein?

Tom Davenport hat hierfür das Delta-Modell entwickelt und dies im Buch «Analytics at Work» vorgestellt. Delta ist ein Akronym und bedeutet: Data Enterprise Leadership Targets und Analysts. Der griechische Buchstabe Delta wird gern als Symbol für «Veränderung» verwendet. Das ist ein bezeichnendes Bild für das Ziel dieses Modells.

Zusammen können wir Ihre Organisation verändern:

D ata: zugängliche, qualitativ hochwertige Daten

E nterprise: Unternehmensorientierung

L eadership: analytische Führung

T arget: strategische Ziele

A nalysten

Warum sind diese Elemente so wichtig? Gute Daten die Voraussetzung für alles Analytische.

Einige der Herausforderungen des Datenmanagements sind viel leichter zu bewältigen, wenn das Unternehmen als Ganzes relevante Daten, eine Analysesoftware und Analysetalente „besitzt“. Zudem soll das Management im gesamten Unternehmen motiviert sein und an analytischen Initiativen mitzuarbeiten.

Sie fragen sich vielleicht: «Aber wir fangen klein an, mit einem spezifischen Problem in einer einzelnen Geschäftsfunktion – warum sollten wir eine Unternehmensperspektive brauchen?» Die kurze Antwort ist, dass Sie ohne eine solche Perspektive aus den folgenden 3 Gründen nicht weit kommen:

- Grosse Analyseanwendungen betreffen immer mehrere Bereiche des Unternehmens; sie verbessern die Leistung und Wettbewerbsfähigkeit effektiv.

- Wenn Ihre Anwendungen funktionsübergreifend sind, macht es keinen Sinn, Ihre Schlüsselressourcen (Daten, Analysten und Technologie) lokal zu verwalten.

- Ohne eine Unternehmensperspektive werden Sie wahrscheinlich viele kleine analytische Initiativen haben, die jedoch unbedeutend sind.

Visionäre Manager betrachten die Entwicklung von analytischen Denkmustern im gesamten Unternehmen als wesentlichen Erfolgsfaktor. Analytisch veranlagte Führungskräfte werden keine Blankoschecks zur Finanzierung von Analytik im Allgemeinen ausstellen.

Was ihre Aufmerksamkeit wirklich erregt, ist die potenzielle Rendite des Einsatzes von Analytik dort; wo sie einen wesentlichen Unterschied macht. Es geht um den nachhaltigen Erfolg mit Business Analytics und Data Governance.

Ein analytisches Ziel kann eine starke Kundenbindung, eine hocheffiziente Supply-Chain-Performance, ein präziseres Asset- und Risikomanagement oder die Einstellung, Motivation und Führung von hochqualifizierten Mitarbeitern sein. Unternehmen brauchen Ziele, weil sie nicht alle Aspekte ihres Geschäfts gleichermassen analytisch angehen können; es gibt nicht genug analytische Talente, um alle Bereiche abzudecken. Analytics braucht gute Ziele. Gute Ziele sind ein eigenes Thema, dessen detaillierte Erläuterung hier den Rahmen sprengen würde.

Analysten haben zwei Hauptfunktionen:

• Sie erstellen und pflegen Modelle, die dem Unternehmen helfen, seine analytischen Ziele zu erreichen

• Sie bringen die Analytik in das Unternehmen, indem sie die Geschäftsführung dazu befähigen, sie zu schätzen und anzuwenden.

Um echte Fortschritte zu machen, müssen Sie also die fünf DELTA-Elemente in das richtige Verhältnis zueinander setzen. Organisationen unterscheiden sich in Ausgangspunkte, Mischungen von Fähigkeiten und Fortschrittsraten bei der Analytik.

Data Governance als wichtiger Erfolgsfaktor

Daten bilden die beste Grundlage für neue Erkenntnisse, wenn sie von verschiedenen Seiten betrachtet werden. Unsere heutigen Umstände erfordern auch Entscheidungen, die unter unsicheren Bedingungen getroffen werden müssen. Solche Situationen sind komplex. Es müssen viele verschiedene Einflussfaktoren berücksichtigt werden.

Eine Entscheidung muss nicht nur den heutigen Massstäben entsprechen. Da viele Entscheidungen einen langfristigen Einfluss haben, müssen sie sich auch in späteren Zusammenhängen bewähren. Denken wir nur an die Einstellung zu Schadstoffwerten im Verbrennungsmotor, in der Atomenergie usw.

Es hat sich bewährt, die verschiedenen Sichtweisen und Anforderungen in die Art des Umgangs mit Entscheidungen einfliessen zu lassen.

Verschiedene Anforderungen benötigen auch einen unterschiedlich festen Rahmen. Wir von CubeServ sprechen hier gerne vom Unterschied der Fabrik, der Werkstatt und des Labors. Das Geschehen in einer Fabrik ist von Effizienz und wiederholbaren Ergebnissen geprägt.

Wir stellen uns hier den Monats- oder Jahresabschluss vor. In einer Werkstatt kommt es viel mehr auf ein einmalig gelungenes Ergebnis an. Eine gute, auf eine entsprechende Zielgruppe zugeschnittene Marketingkampagne ist zu einem bestimmten Zeitpunkt gültig. Die nächste Kampagne benötigt eine andere Segmentierung. Und zuletzt das Labor: Ideen müssen hier zügig validiert werden.

Das Ziel besteht darin, vielversprechende Ideen weiterzuverfolgen und weniger aussichtsvolle zu verwerfen.

Wir sehen das erfolgreiches Business Analytics und Data Governance eng zusammenhängen.

Das Governance-Konzept setzt folgende technische und fachliche Richtlinien und ist für eine erfolgreiche Umsetzung massgeblich:

- BI-Organisation etablieren

- KPI-Definitionen: Erarbeitung eines Katalogs mit Verantwortlichkeiten und Abnahmen

- Modellierungsrichtlinien: Vorgaben und Regelungen im Rahmen der Datenmodellierung

- Anforderungserhebung: Template mit Muss-Inhalten

- Entwicklungsstandards: Festlegung von Richtlinien zur Entwicklung/Programmierung, inklusive Transportwesen

- Namenskonventionen: Vorgaben bei der Namensgebung von Objekten festlegen. Ziel ist der Aufbau eines Frameworks zur Definition von Fragen und Lösungen.

- Testkonzept mit der Definition Quality-Checkpoints

- Berechtigungskonzept: Aufbau eines Konzepts, welches mit den Umsystemen kompatibel ist.

Wir können heute über unsere Kunden wieder genauso viel wissen, wie es zu Zeiten des Eckladens üblich war.

Dieses Wissen lassen wir in unsere Angebote gezielt einfliessen.

Wir wollen Kunden abholen, wo sie stehen, und Ihnen das zu bieten, was sie brauchen. Das lohnt sich für die Kunden und wir profitieren von einer wertvollen Beziehung.

Added Value:

Dank Mustererkennung werden kundenindividuelle Wertangebote erstellt. So festigen wir die Kundenbindung und heben uns von Wettbewerbern ab.

Potential & Benefit:

Schnelle und fundierte Erkennung von aussichtsreichen Kunden durch Zugriff auf valide und jederzeit aktuelle Daten. Wir haben eine bessere Ergebniskontrolle der einzelnen Kundensegmente.

Bisher veröffentlicht:

- Teil 1: Wie Business Analytics erfolgreich gestalten?

- Teil 2: Business Analytics vs. Business Intelligence

- Teil 3: Was ist SAP Analytics? Das SAP Data Warehouse-Portfolio

- Teil 4: SAP Analytics – Die Front End Produkte

- Teil 5: Data Plattform – Ein wichtiger Pfeiler der digitalen Transformation

- Teil 6: Auf dem Weg in die AWS

- Teil 7: Cloud – Fluch oder Segen?

- Teil 8: Mit Daten führen – warum Power BI häufig zur Auswahl steht